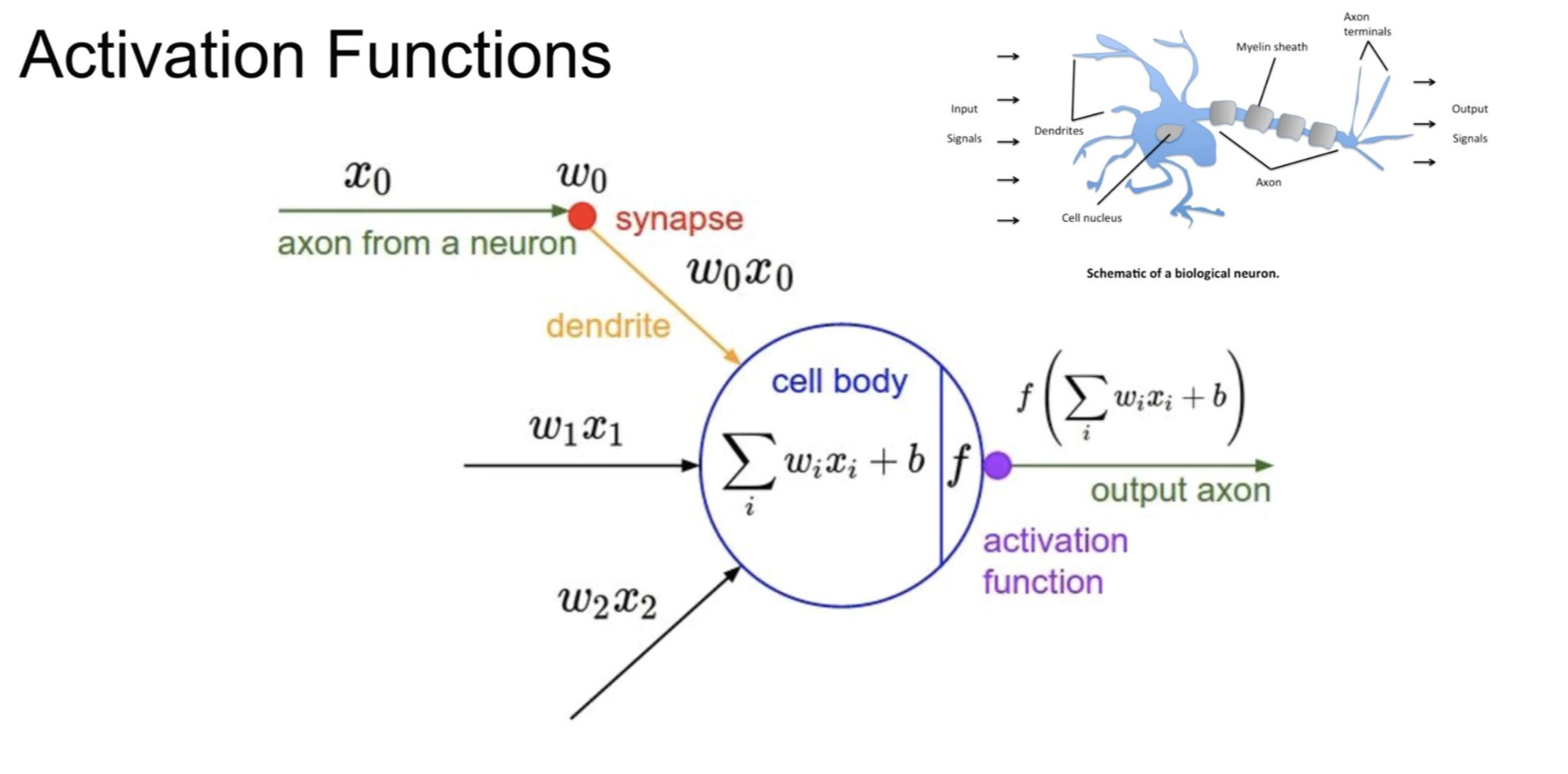

Activation Functions

x라는 값이 들어오면 w(weight: 가중치)를 곱해주고, 그 값들을 전부 더한 다음 b(bias)를 더해줍니다.

activation function: 앞에서 구한 값이 특정한 값을 넘어가면 '1'이라는 신호를 주고, 특정한 값보다 작으면 '0'이라는 신호를 줍니다.

AND/OR problem & XOR problem

Linear separable?

AND와 OR 둘 다 linear separable 합니다.

그러나 XOR은 linear separable 하지 않습니다.

MLP를 이용한 XOR

여러 개의 MLP를 이어붙이면 XOR를 linear하게 사용할 수 있습니다.

그러나 아무도 각각의 w와 b를 학습시킬 수 없다고 주장하였습니다.

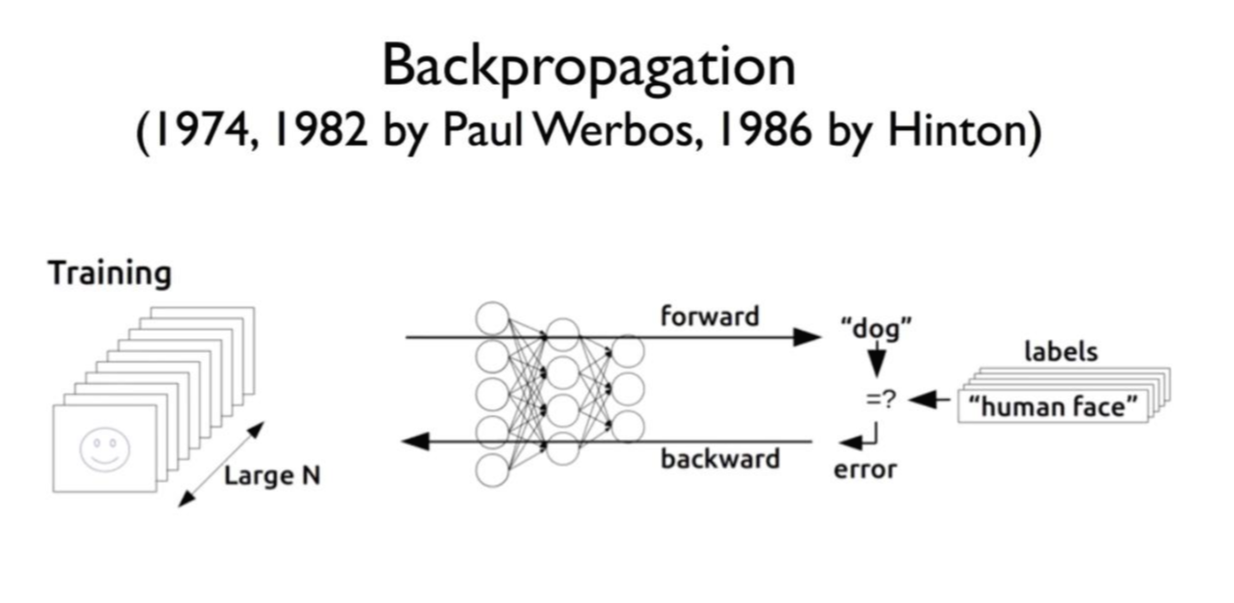

Backpropagation(역전파)

주어진 입력을 가지고 출력을 만들어낼 때, 그 출력이 실제 값과 차이가 있으면 w와 b의 값을 조절해야 합니다.

w와 b 값을 조절하기 위해 에러를 뒤로 전달해가며 각각에 피드백을 주며 학습시키는 방법이 '역전파'입니다.

이 방법을 통해 xor을 포함하여 여러 형태의 복잡한 방법의 해결이 가능해졌습니다.

Convolutional Neural Networks

특정한 그림을 주면 일부 뉴런만 활성화되고, 다른 그림을 주면 다른 뉴런이 활성화되는 것을 발견했습니다.

우리의 신경망은 그림을 전체적으로 보는 것이 아니라, 부분적으로 담당하는 것들이 정해져 있다는 추측을 했습니다.

이것을 이용해서 하나의 그림을 여러 부분으로 잘라서 보낸 후, 부분부분을 나중에 합치는 방법을 이용하는 네트워크를 사용했습니다.

ex) 자율주행차, 터미네이터 영화 등에 이론이 활용됨

BIG Problem

backpropagation은 에러를 뒤에서부터 거꾸로 전달하는 방식인데, 거쳐야 할 layer가 많은 경우에는 뒤에서부터 전달되는 도중에 의미가 갈수록 약해져서 처음 layer에 도달했을 때 에러가 거의 전달되지 않는 문제가 발생할 수 있습니다. 따라서 many layers를 이용하는 경우에는 성능이 떨어지게 됩니다.

Breakthrough

in 2006 and 2007

-2006 논문: 초기값을 적절히 선택하면 학습이 가능하다.

-2007 논문: 깊게 신경망을 구축하면 복잡한 문제가 해결 가능하다.

Rebranding

neural networks에서 Deep Nets, Deep Learning으로 이름 변경

ImageNet

-이미지를 주고 어떤 이미지인지를 맞추도록 하는 것(정확도가 90% 이상이 되어야 사용 가능)

-2015년에 에러 발생률이 5%대로 줄어들었습니다.

Why shoud I care?

사용 사례

1. 유튜브의 자막-영상의 소리를 듣고 자동으로 자막을 만들어내는 것

2. 페이스북-관심을 가질만한 피드를 학습을 통해 보여줌

3. 구글 검색 엔진-검색을 통해 나오는 정보들 중 클릭할만한 문서를 학습을 통해 예측하여 보여줌

4. 넷플릭스, 아마존 등-추천 서비스

'인공지능' 카테고리의 다른 글

| [Tensor Manipulation] Stack & Ones and Zeros like &Zip (0) | 2021.01.23 |

|---|---|

| [ 다차원 배열의 축] Axis (0) | 2021.01.23 |

| [Tensor의 구조] Shape & Reshape (0) | 2021.01.20 |

| [Training Neural Network] epoch, batch, and iteration (0) | 2021.01.20 |

| [Optimizer] Optimizer의 종류 (0) | 2021.01.19 |